在开始之前,先补充一下离散信源的一些知识点。 平均互信息公式是这个:

如果是两级信道则会有平均联合互信息:

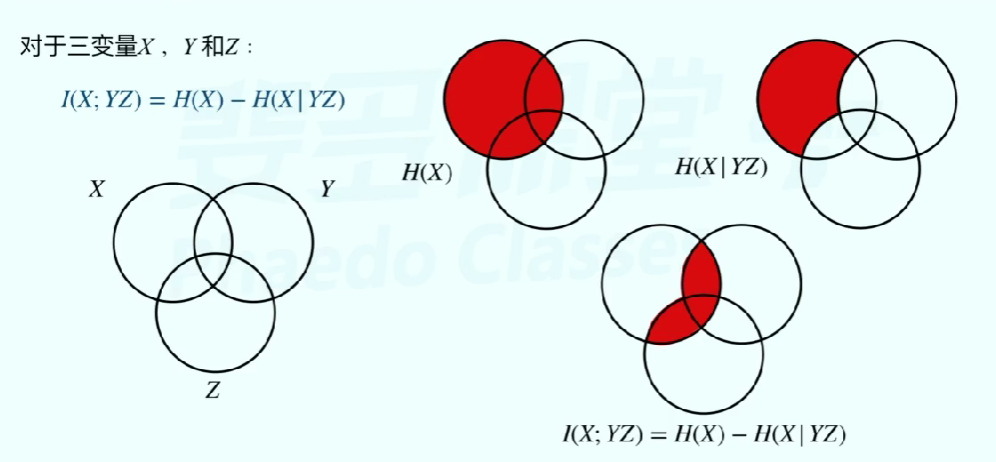

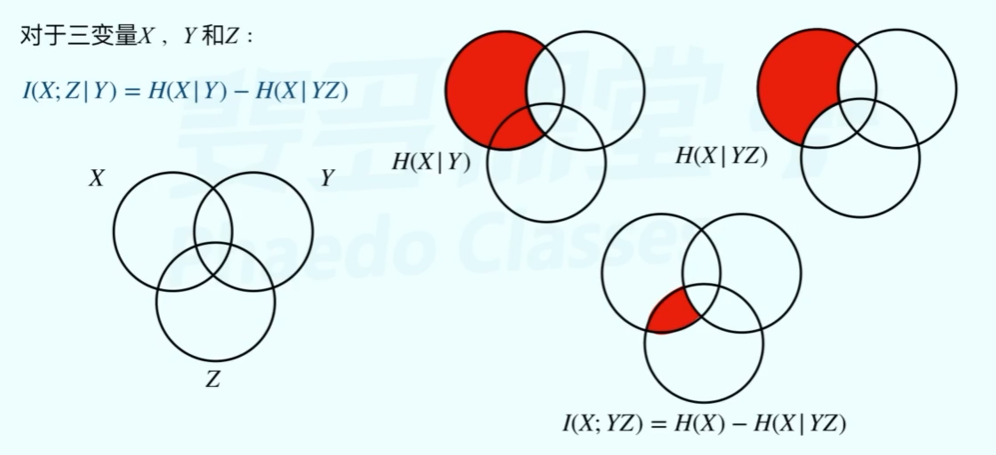

就是一个替换关系,在互信息这个概念前可以有三种前缀:平均、联合、条件。平均其实就是每个单独互信息的期望,是一个统计参数。联合就是多个事件联合发生的互信息,条件则是在指定某事件下的互信息。

最简单的条件互信息如下:(在说联合和条件互信息的时候是省略了”平均“)

联合互信息也可以写成条件互信息相加:

都可以通过维拉图推导记忆。

第四章-波形信源与信道

连续信源和波形信源

在概念上连续信源和波形信源是一个东西,时间和取值都是连续的,连续信源可以用一个连续型随机过程来描述,但很显然本课程只讨论最基础平稳过程,因此每一时刻的概率密度函数是固定的,连续信源的数学模型如下:

我们可以对这个连续的概率密度函数取无穷小区间求和再取极限得到连续信源的绝对熵:

连续信源的绝对熵是一个无穷大的量,因此我们取前一项作为它的熵,定义为差熵:

和就是区分差熵和绝对熵的标志,类比离散信源差熵也具有可加性、强可加性、凹凸性等性质,但是差熵可以为负,这一点要注意。

特殊信源的差熵

均匀分布

均匀分布概率密度如下:(省略定义域)

不难推导出差熵为:

我们也可以推导出在峰值受限条件下信源的最大熵就是均匀分布的差熵。

高斯分布(正态分布)

高斯分布概率密度有点复杂但是一定要记住:

想推导它的差熵其实并不复杂,其均值,交流功率,利用这两个统计量的计算式展开将大大减少计算量,其差熵为:

可以看出信息量与均值无关,均值反应的是直流功率,这就解释了为什么在通信系统当中为什么想尽办法减少直流功率,因为直流功率不传递任何信息。所以在信息论中讨论功率的时候常常就等于方差,但其实方差严格意义上代表交流功率,只是我们尽可能使直流功率为0。

一个很重要的定理就是在平均功率受限的条件下信源的最大熵就是高斯分布的差熵。

高斯分布的差熵也常写成:

熵功率

任何一个信源可以通过其熵计算熵功率:

熵功率与它真实的功率之差称为剩余度,但我发现差熵计算以

在功率受限的情况下,根据这个公式就可以知道高斯分布的剩余度最小。(教材说是

连续信道和波形信道

在教材上这两者是有区别的连续信道是对波形信道的采样,也就是说连续信道在时间上是离散的,这也符合我们对随机过程的想象,再某一时刻取样然后去研究这时候的统计特性。

虽然教材强调了这两者的区别,但是再做题和理解的时候基本都是用的连续信道,教材又讨论了信道的分类,和通信原理中的基本一样,这里主要探讨加性信道,并且噪声熵有其重要特性:

在离散信道一章中花大量篇幅去定性分析这个噪声熵,使它“名副其实”,但从连续信道角度上去理解才是最为直观,噪声熵就是”噪声的熵“。

噪声中最为著名的就是高斯白噪声,那它的熵如何计算不言而喻,这在后续将会经常出现。

信道容量

连续信道也有互信息的定义:

信道容量就是互信息的最大值,当我们规定信道为**加性高斯白噪声信道(AWGN)**就可以推出著名的香农公式:

这三者都是香农公式,它们的关系是层层递进推导出最后一个香农公式,这个公式一样可以用于离散信道,因为只要是物理信道,实际上就是波形信道,经过采样判决成为连续信道逐步推导过来。因为AWGN是最差信道,所以这个公式导出的是带宽受限信道的容量下限。

由于信噪比可以进一步展开,因此可以推出香农限:

这个1.44非常迷惑人像

这章的题目不会考特别难,基本都是给定一个离散模型,算出信息量,然后问要用多大带宽传输,或者说压缩比固定后带宽的变换,都是对香农公式的变形计算。

剩下的5,6,7,8章将是考试重点。